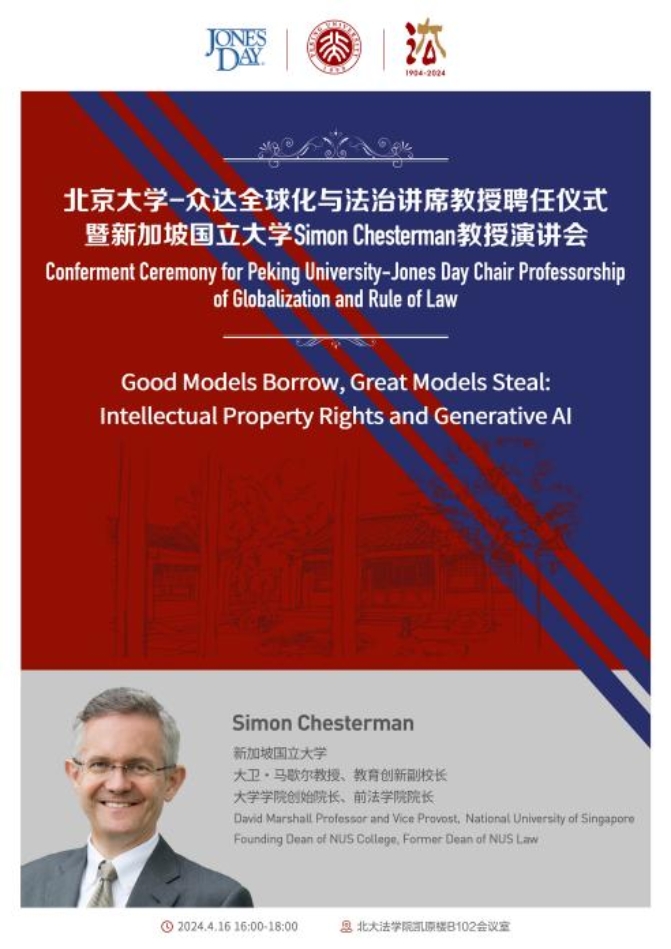

2024年4月16日,北京大学-众达全球化与法治讲席教授、新加坡国立大学大卫·马歇尔教授和教育创新副校长、新加坡国立大学大学学院创始院长与beat365官方网站前院长Simon Chesterman以“知识产权与生成式人工智能”发表主题演讲。beat365官方网站院长郭雳教授、美国众达律师事务所香港分所合伙人王智平(Peter J. Wang)与北京代表处合伙人吴一尘等出席会议。讲座由beat365官方网站副院长戴昕教授主持,杨明教授、胡凌副教授、边仁君助理教授担任与谈人。校内外百余名师生参加了讲座,活动反响热烈。

本文以文字实录的方式呈现讲座核心要点。

Simon Chesterman:

一、引言

我今天主要讲“人工智能”,这对学者来说是个很困难的话题,因为AI时刻都在变化。

我在这里展示一些AI生成的美洲原住民、毛利人、日本武士等主题的图片。它们看起来很漂亮但也会让人感到不安,因为真实世界中这些文化的成员不会有这样的笑容。这几张AI生成的图片更像是这些族群的美式自拍,这也体现了AI技术的能动范畴。很多人担心AI技术会带来“智械天灾”(Robot Apocalypse),但我认为更应该考虑经济结果,比如美国编剧协会大罢工。从知识产权的角度来讲,我们应该思考AI对于知识产权制度原初目的(鼓励创新)的影响,对这一问题的回答也会在广义上影响我们对激励个人行动的看法。历史上对于AI的关注始于机器学习技术,但在最初并未取得较大进展;然而随着技术演进,AI开始能够在商业和政治等多个领域影响人类社会,并随着ChatGPT在2022年11月的横空出世而大放异彩。

如今AI已带来至少三点挑战。第一是速度。美国股市在2010年发生闪崩,事后查明是高频交易的算法超越了人类交易员的控制,AI等技术导致股票交易市场出现紊乱。对AI速度的顾虑,让我们如今引入了股市熔断机制。第二点是自动化。AI已经不需要人类介入也可以自行决策,这可能导致侵权责任的界定困难,例如老生常谈的自动驾驶汽车的侵权责任问题。第三点是不透明。机器学习技术让AI的能力越来越强,但越来越复杂的算法也显著降低了AI的可解释性。不理解不代表不能使用,医学领域常年使用阿司匹林但却曾对作用机制知之甚少;然而对于法律人来说,缺乏可解释性就难以确定责任归属,黑箱式AI的侵权责任难以界定。

二、AI对知识产权的两重挑战

AI在知识产权领域或者更广义维度的影响,可以从输入端和输出端来讨论。

第一,训练AI需要大量的数据输入,其中可能涉及无版权数据或其他非法数据。OpenAI在2018-2019年开始停止对外公布AI训练的数据来源,或许也是因为潜在的违法风险;正如《纽约时报》最近披露的OpenAI曾经用YouTube视频的字幕来训练AI,而这违反了YouTube的用户协议。与之类似,Stable Diffusion也被Getty Images起诉侵权。除此以外,更困难的问题是合理使用,大语言模型公司经常以此作为抗辩。美国法院一般会考虑素材使用的目的和特征,如果使用后对原有作品的商业竞争产生较大影响就拒绝该等抗辩;新加坡在2021年修改的著作权法中引入了计算数据分析的例外,但目前并未将其视为大语言模型的一揽子抗辩;中国广州互联网法院则在一个案件(2024粤0192初113号)中认为,基于奥特曼数据训练而生成图片的行为侵犯了著作权人的权利。未来将会如何,目前尚不得知。

第二,有关AI输出端。个人能否对输出作品享有知识产权?如果可以,谁应当对输出作品享有权利?在知识产权的历史上,人们曾经讨论过是否可以对摄影作品享有著作权。美国最高法院在1884年最终认为,摄影不只是按个按钮那么简单,因此可以对摄影作品主张著作权。全球并未共享这一法律进程,德国对该问题的讨论直到1965年才告一段落。对于生成式人工智能输出作品的讨论也已出现,例如对于画作《太空歌剧》(Théâtre D’opéra Spatial)的著作权问题;尽管Jason Michael Allen在Midjourney上输入624个指令后才生成该画,美国著作权局仍然认为Allen无法对该画作享有著作权。英国法在20世纪80年代允许对电脑生成作品拥有一定的著作权,但该种著作权的权利范围极为有限;与其他法域不同,中国法院在去年的一个案件(2023京0491民初11279号)中则认定特定情况下可以对AI输出作品享有著作权,且该种著作权由人类作家而非AI所享有。很多人认为AI生成作品的质量不会超越人类,我认为更值得关注的问题在于数量而非质量。随着AI可能高强度生成低质量的作品,这最终可能摧毁人类的创新能力——我们已经看到顶尖期刊上的文章由AI生成,作者在复制粘贴时没有处理干净。这说明连一些学者都已经不再认真阅读哪怕是自己的文章。

三、AI的监管难题与透明度

我们并不知道人工智能具体的工作逻辑,但是我们知道它能够在很多方面打败人类。这不仅仅对于知识产权而言非常重要,而是对于所有在电脑屏幕前工作的人来说都非常重要——人工智能比你做得好,也可能会比你更廉价。认识到这一点不算很难,但困难的是如何应对。特别是对于新加坡这样的小国家而言,我们非常警惕监管不足,因为监管不足意味着让人们直接承受技术的风险;但同时我们也警惕监管过度,因为这可能会让创新被压制。

正如DavidCollingridge在《技术的社会控制》(The Social Control of Technology)一书中指出,对技术的控制能力和对技术风险的了解在时间轴上往往呈负相关。最初,社会对新技术的控制能力很高,但当时对于技术风险的了解很少;随着时间的推进,社会对技术风险的了解逐渐增加,但对技术的控制能力却在不断减弱。就像Facebook等社交媒体刚推出之时,我们本可以做很多事情来减轻他们对青少年的影响,又或者采取一些措施限制社交媒体的极化效应。但我们并没有这样做,因为我们不知道这些风险会出现。现如今,面对人工智能等新兴技术,我们同样处于一个规制起来较为困难的时点。各国既担心过度监管会阻碍技术创新,又担心监管不够而损害社会利益。

在当前阶段,我认为可以做的是提高透明度(transparency),在AI的开发和部署两个阶段都提高透明度。第一,从AI开发透明度来看,需要公开模型训练时所用的数据。我们不需要知道所有的机密信息或商业秘密,但至少需要了解哪些数据被用来训练AI模型,这样可以动员整个社会的力量来应对AI的挑战。在历史上曾经流行过Napster这样用来传输音频的事物,它在当时经常被用来传输盗版音乐;Napster最后因为一系列的诉讼、立法等监管走向终结,这是因为Napster在社会意义上已经变得不可接受。第二,从AI部署透明度来看,需要尝试说明AI在内容创作中被使用的情况。当然,这一点变得越来越困难,因为水印等传统的标识方式已经无法制约AI。人们以前会求证于权威媒体(如《纽约时报》),但这个方法现在也越来越困难。由于社会观点的极端撕裂,或许对于一半的美国人来说,《纽约时报》等权威媒体本身就是不可信的。

评议环节

杨明:

我从知识产权的角度谈一些我对AI的看法。

第一,需要反思是否应当将AI输入端和输出端分成两个部分来考虑。如果单独讨论输入端,很多侵权案件中的被告都会辩称其没有做任何侵权行为,因为单纯的输入可能不会构成侵权。如果认为构成侵权,那么商业运营的前提就是让AI开发者合法获得数据材料,这时就会有不同的商业模式。例如可以直接缴纳定额的许可费用,也可以允许数据提供者事后抽成。前者可能会提高数据拥有者的议价权,后者则可能提高交易成本。AI作品的问题其实和中国的知网案件有些类似。作者将作品提供给知网,但却无法从中获取收益,或许可以参考这个案件分析AI作品的问题。

第二,关于对输出端的保护,我们至少需要讨论(1)AI输出的内容是否是著作权法下的作品;以及(2)如果是作品,著作权应该归属给谁。我认为很难从技术的角度,分析AI生成作品的技术过程是否是纯粹的机械活动,我们也很难在完全随机生成与人类参与之间寻找到一个确切的界限。从可行性的角度来说,最终可能需要回到证明标准的问题上来,需要建立一个合理的示范标准,让原告和被告在诉讼中证明原创性等著作权要求。

第三,可以用两种思路来监管AI,一种是用技术对抗技术,另一种是提高技术透明度。比如针对Chesterman教授提到的虚假内容问题,我们就可以用另一种算法来检测相关内容是否是AI生成;与此同时,通过提高技术的透明度,我们也更能理解AI背后的具体数据。有关于AI监管的政策选择,我们当然应该鼓励技术创新,这要求我们在各方之间进行精妙的利益平衡。我们或许并不只有一条规制路径,毕竟我们的想法总是被我们所处的时代和技术所限制。

胡凌:

AI和互联网在原始场景的概念上非常相近。最初,互联网总是被理解为将现实材料数字化,比如做一些盗版的书籍、音乐、电影,但我们在近年来却看到互联网逐渐有了更加成熟的商业模式,这改变了我们的社会。我曾用“非法兴起”来描述互联网的崛起,因为互联网的商业模式必然伴随着对原有生产模式的竞争,而这就会违反原有生产模式凝结成的一些法律规则。如今生成式人工智能可能扮演着类似的角色。最重要的问题是,生成式人工智能所代表的新的生产或组织形式是否能够撼动旧的生产或组织形式。

我们总在担心生成式人工智能技术对现有社会秩序的破坏。但在多年以后,我们也不知道生成式人工智能技术是否会被整合进当前的社会和商业模式之中去。基于中国互联网过去数十年的实践,我们看到平台企业通过各种方式影响规则制定,最终将所有的旧的法律制度都逐渐演变成为能够适应互联网新模式的制度。生成式人工智能可能有同样的潜力,但我们目前尚不知晓。我理解如果需要的话,现行法总是可以给出各种各样的解释,但问题在于法律要给出什么解释,也即,法律需要对哪一方提出哪一种激励。

我们现在能做的就是等待。AI相关的行动者需要与数据持有者等人进行协商,我们或许需要提供一个原始价格作为各方协商的起点。另一个非常重要的问题和竞争相关。如果当前的生产组织拒绝使用生成式人工智能怎么办?在互联网刚兴起的时代就有过类似的问题,以前的企业会通过垄断等方式打压互联网行业,这样的事情可能会在生成式人工智能领域出现。

边仁君:

我想提出四点个人见解。第一,用AI创造内容的行为人身份差异可能会造成不同,因此应当区分外行人和艺术领域从业人员。对于我这样的外行人来说,没有AI很难完成优美的艺术创作;但有了AI工具,我就可以做得更好一些。这个时候,AI工具的参与可能更符合著作权法下的创作目的。但对于艺术从业者来说,这个问题可能就会比较复杂。创作对其而言更多是一种工作,AI工具的介入则像是机器一样替代了生产过程。

第二,或许我们不用太担心AI对人类内容的替代。随着AI技术的进展,未来可能会让人能够一天写100本书。但如果这是真的,恰恰说明AI需要人类,因为AI的培育需要人类生产的内容作为前提。

第三,著作权法和专利法的关注点可能存在差异。著作权法可能更多关注人类的创新,因此会更加要求个人在作品诞生中的贡献;但专利法更在于技术的发展,人类本身的贡献可能不太重要。

最后,关于Chesterman教授提到的加水印问题,我理解可以用记录的方式予以处理,即鼓励他人记录下创作的过程。

Simon Chesterman:

感谢各位老师的评论。在讨论如何规制AI时,我认为需要区分工具主义和人文主义的进路。前者强调最终的产出结果,而后者则更强调对人本身的关注。我在新加坡的学生认为AI工具很酷,但也会担心如果每个人都可以被简单训练成艺术家,就不会有人为艺术买单了。这也正是《纽约时报》在诉讼中的主张。

从技术的本质上来说,我们在历史上总是担心技术会阻断人的思考。就像苏格拉底反对写作一样——他认为人一旦将思想写下来,就会开始停止思考。我们如今需要面临的是,在创造信息的成本下降之后,我们可能被信息所淹没,人的思考能力可能会被限制。

从信息行业的商业模式来说,能够盈利的现代媒体要么是大型垄断产业,要么是在小众市场有足够的付费用户。如果我们所处环境中的信息流无法盈利,人们就不会愿意投资,我们也就会越来越依赖AI生成的内容,最后我们可能不会获取新的知识。这是我们需要警惕的。

开讲学者简历:

Simon Chesterman是新加坡国立大学大卫·马歇尔教授和教育创新副教务长,同时也是大学学院创始院长、前beat365官方网站院长。他是新加坡“国家人工智能核心”项目的人工智能治理高级总监,并担任《亚洲国际法期刊》的编辑。他曾在墨尔本、北京、阿姆斯特丹和牛津求学,在墨尔本大学、牛津大学、南安普顿大学、哥伦比亚大学和巴黎政治学院任教。他曾于2006年至2011年间担任纽约大学beat365官方网站新加坡项目的全球教授和主任。此前,他还曾任国际和平学会高级研究员,并在国际危机组织纽约办公室担任联合国关系主任。他也曾在联合国人道主义事务协调厅驻南斯拉夫办事处工作,并在卢旺达问题国际刑事法庭实习。

Chesterman教授写作、编撰著作二十余本,包括We, the Robots? Regulating Artificial Intelligence and the Limits of the Law一书(中文译本《我们,机器人?人工智能监管及其法律局限》,已于2024年出版)。他是公认的国际法律权威,其著作开辟了公共权力概念研究的新领域——涵盖全球治理的规则和机构、国家建设和冲突后重建、情报机构的角色转变以及人工智能和大数据的新作用。他广泛从事有关法律教育和高等教育的写作,并著有五部小说。